Gammichan

現在、コンテンツはありません

Gammichan

- 報酬

- いいね

- コメント

- リポスト

- 共有

- 報酬

- いいね

- コメント

- リポスト

- 共有

どれほど彼らの収益に影響を与えるかは言い難いですが、AMDの新しい「Halo Strix」プロセッサーは、ローカルLLMを実行したい人にとって最良のシステムとなりました。

これらのうちの1つを128GBのRAMで約$1.5kで手に入れることができ、gpt-oss 120Bのような中/大規模モデルを完璧に実行します。

参考までに、単体のNvidia 5090 (は、他のPC)なしで2-3千ドルであり、そのフルモデルを実行することはできません。

64GBのRAMを搭載したMac miniは2,000ドルで、そのフルモデルを実行することもできません。

128GBのRAMを搭載したMac Studioはそれを実行できますが、3.7kドルかかります。

原文表示これらのうちの1つを128GBのRAMで約$1.5kで手に入れることができ、gpt-oss 120Bのような中/大規模モデルを完璧に実行します。

参考までに、単体のNvidia 5090 (は、他のPC)なしで2-3千ドルであり、そのフルモデルを実行することはできません。

64GBのRAMを搭載したMac miniは2,000ドルで、そのフルモデルを実行することもできません。

128GBのRAMを搭載したMac Studioはそれを実行できますが、3.7kドルかかります。

- 報酬

- いいね

- コメント

- リポスト

- 共有

- 報酬

- いいね

- コメント

- リポスト

- 共有

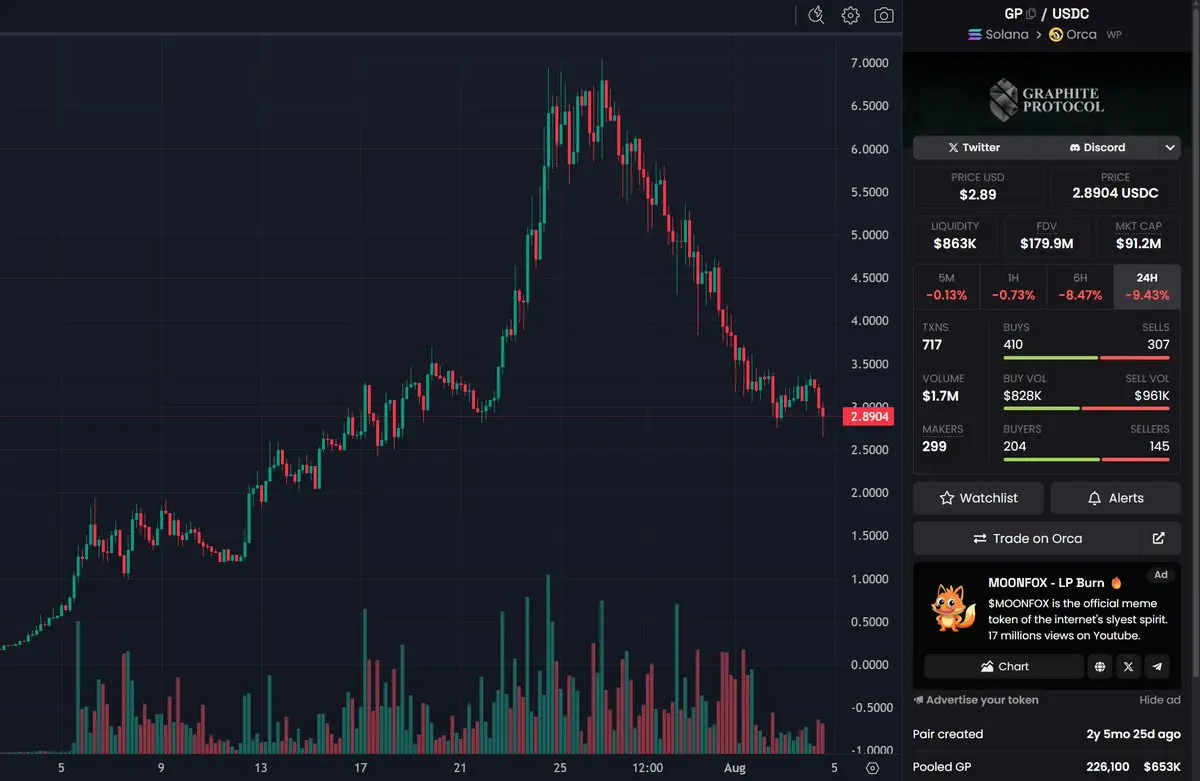

私が個人的に上昇し続けている高MCトークンを購入するのが難しい理由の素晴らしい例です。

私はGPを約3.50ドルでパスしましたが、それは「間違った」決定でした。なぜなら、そこからほぼ倍になったからです。しかし、私の個人的なリスク管理に合わなかったので、パスしました。7ドルから3ドルへのこの下落は、3ドルから1.50ドルへの下落と同じように簡単に起こり得たことで、もし私がそれを買っていたらイライラしていたでしょう。4ドル以上で買って保持していた人たちが今イライラしているのと同じように。

チャートがいつか修正を受けるのは避けられないことで、たとえそれらが根本的に健全であっても、( GPのように)、非常に多くの保有者が利益を得ており、そのポジショニングは一度もリセットされていないからです。人々が自分のuPNLを回転させたくないため、ますます多くの人が離れていくにつれて、連鎖的な売りが発生します。

基本的に私の言いたいことは、上昇のみのチャートに投資するのは難しいということです。なぜなら、修正が来るかどうかの問題ではなく、いつ修正が来るかの問題だからです。あなたはその部分のかなり前に購入して大丈夫かもしれませんし、購入した直後に修正されるかもしれません。購入時には本当に知る方法はありません。

個人的には、それは私のリスクフレームワークに合わないものであり、管理する良い方法がないリスクを取る

原文表示私はGPを約3.50ドルでパスしましたが、それは「間違った」決定でした。なぜなら、そこからほぼ倍になったからです。しかし、私の個人的なリスク管理に合わなかったので、パスしました。7ドルから3ドルへのこの下落は、3ドルから1.50ドルへの下落と同じように簡単に起こり得たことで、もし私がそれを買っていたらイライラしていたでしょう。4ドル以上で買って保持していた人たちが今イライラしているのと同じように。

チャートがいつか修正を受けるのは避けられないことで、たとえそれらが根本的に健全であっても、( GPのように)、非常に多くの保有者が利益を得ており、そのポジショニングは一度もリセットされていないからです。人々が自分のuPNLを回転させたくないため、ますます多くの人が離れていくにつれて、連鎖的な売りが発生します。

基本的に私の言いたいことは、上昇のみのチャートに投資するのは難しいということです。なぜなら、修正が来るかどうかの問題ではなく、いつ修正が来るかの問題だからです。あなたはその部分のかなり前に購入して大丈夫かもしれませんし、購入した直後に修正されるかもしれません。購入時には本当に知る方法はありません。

個人的には、それは私のリスクフレームワークに合わないものであり、管理する良い方法がないリスクを取る

- 報酬

- いいね

- コメント

- リポスト

- 共有